近期,知名AI专家Nathan Lambert在其个人博客上分享了他的关于open model 生态现状的总结(具体链接见文后),衡量Qwen、DeepSeek、Llama、GPT-OSS、Nemotron以及所有新进入者对开源LLMs生态系统的影响。

📝 核心摘要

基于Nathan Lambert对ATOM项目及Hugging Face数据的最新分析,梳理出当前开源生态的四大关键趋势:

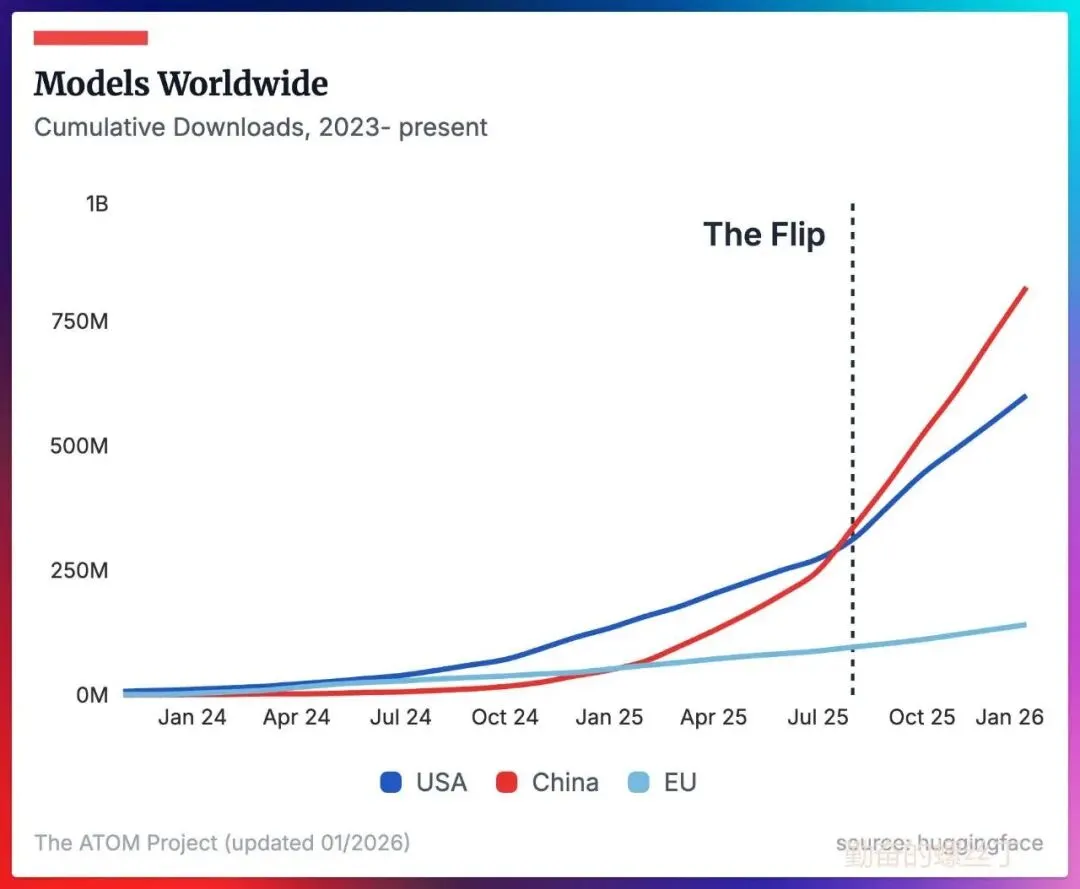

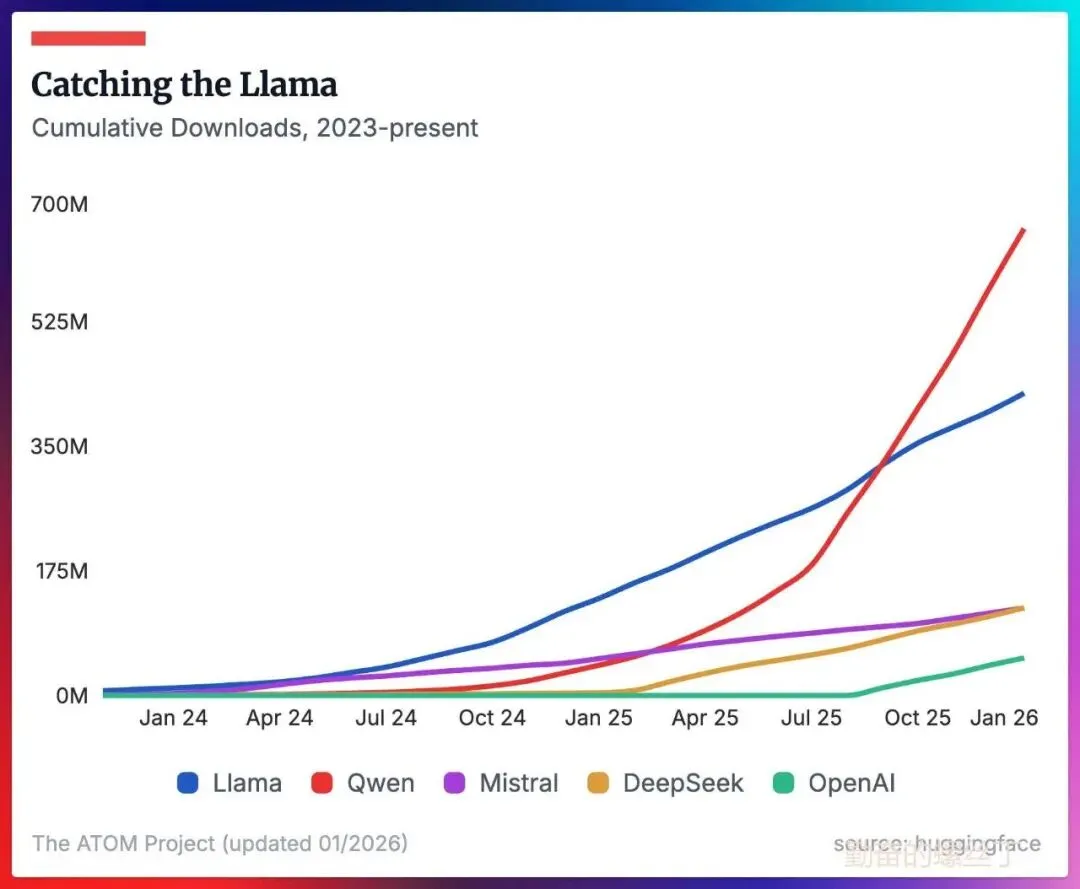

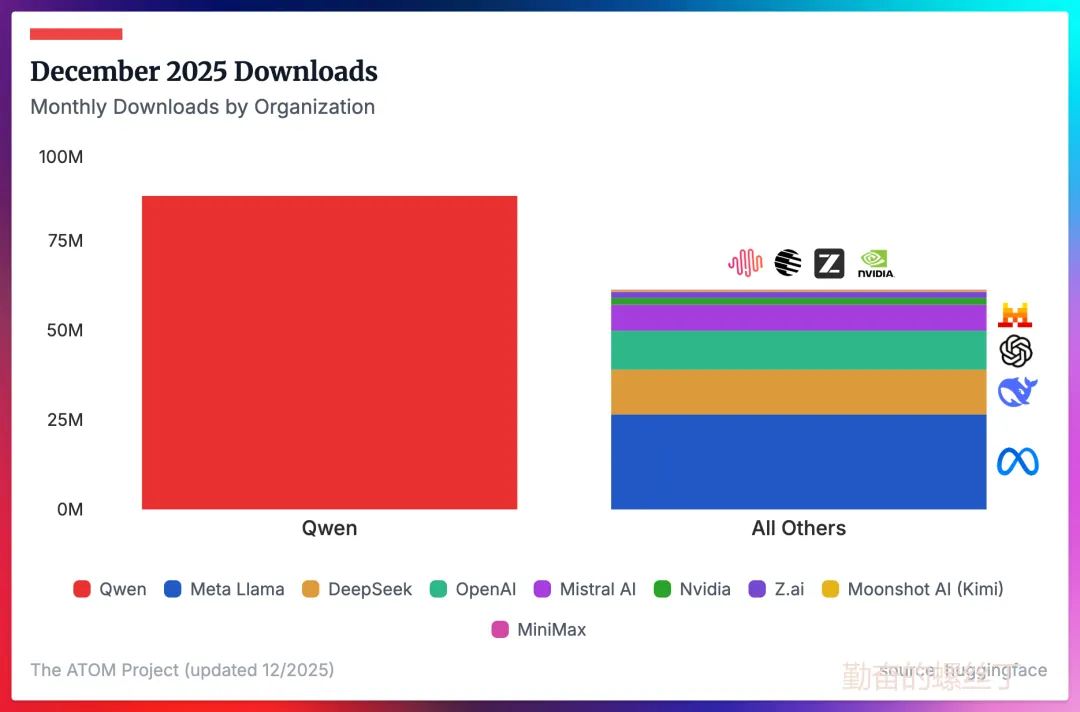

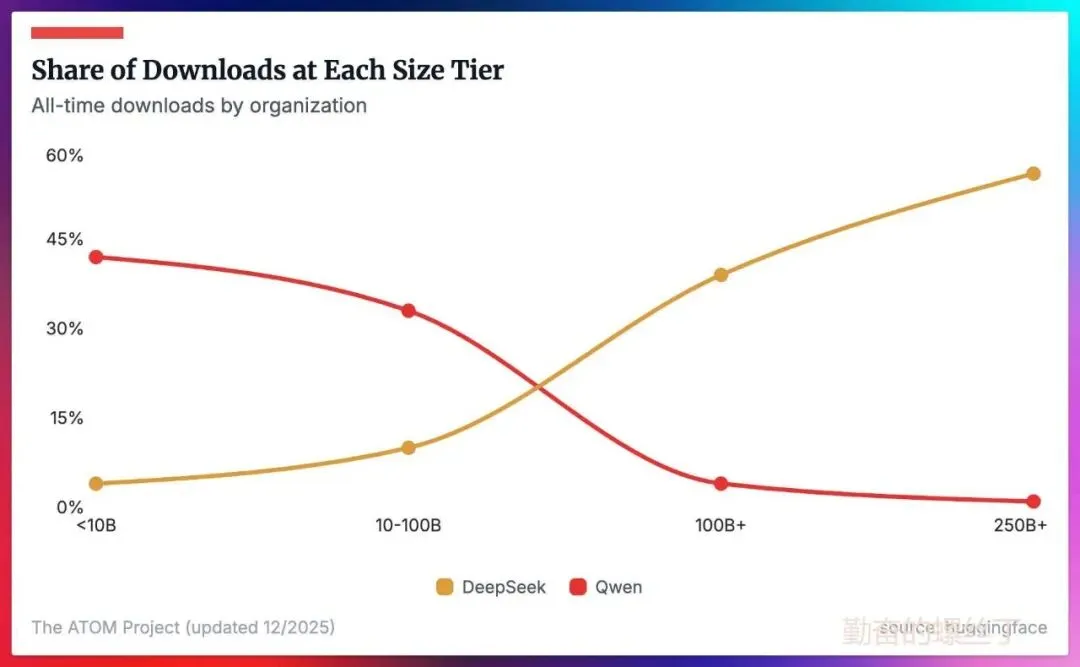

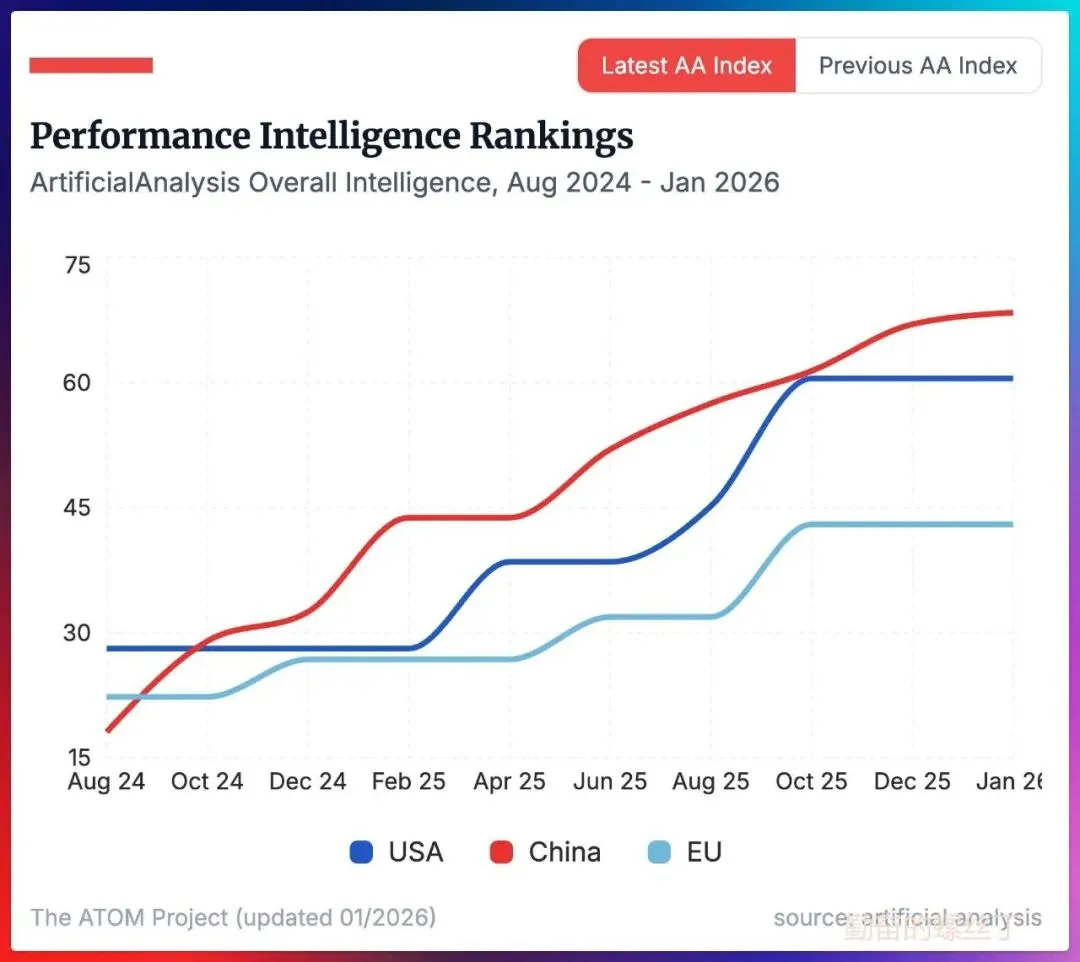

1. 中国开源模型确立领先优势:无论是在采用率(Adoption)还是性能基准上,中国模型均表现强势。Qwen (通义千问) 在广泛的生态位中占据主导,而DeepSeek (深度求索) 则在大模型领域表现卓越,两者共同推高了中国模型的市场份额。

2. 西方开源生态面临“后Llama”真空期:Llama系列在停止更新后,西方社区至今未涌现出能够完全替代其生态地位的新模型。尽管存量巨大,但缺乏增长动力。

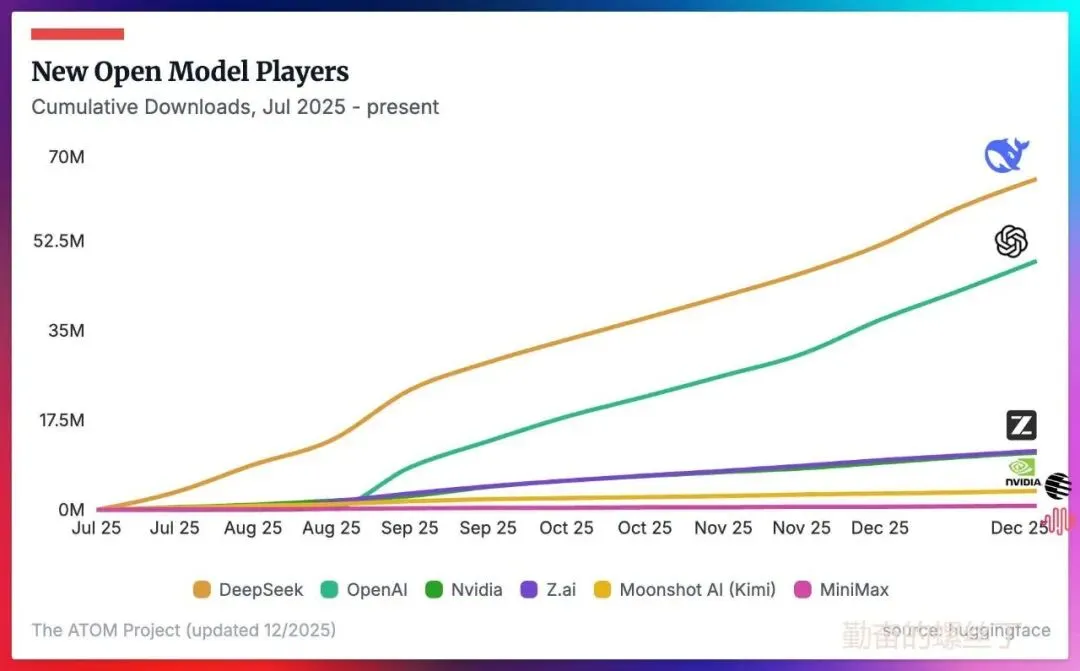

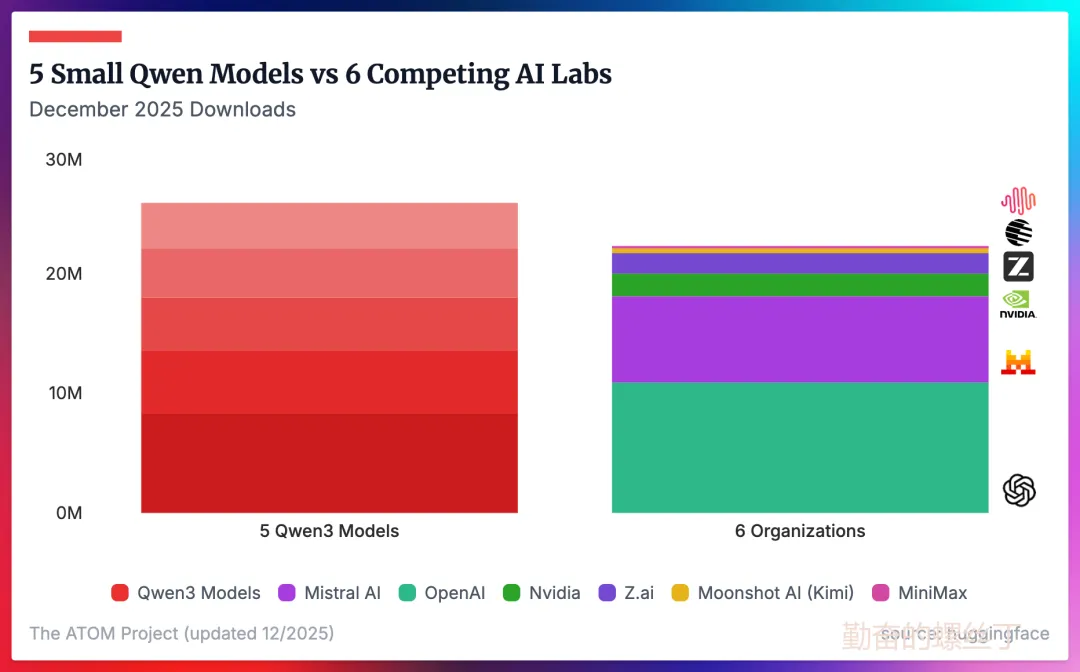

3. 新兴厂商的全球突围仍需时日:尽管Nvidia、Z.ai、Kimi (Moonshot) 和MiniMax等机构动作频频,但在反映开发者实际使用的下载量和微调数据上,目前仍处于起步阶段,尚未对头部模型构成实质性挑战。

4. Qwen成为开源社区事实标准 (De Facto Standard):除超大参数(70B+)领域外,Qwen已成为全球下载量最高、微调最活跃的模型系列,实质上接棒Llama成为新的通用首选。

进入2026年,全球开源AI生态的重心正在发生结构性偏移。以下是基于报告数据的深度解读:

01

默认选项的更替:

从Llama到Qwen

“2025 年标志着Llama时代的终结,Qwen成功接棒。”

Llama的存量现状:尽管Llama模型既未更新也未获得Meta的持续支持,但依靠早期的生态积累,它依然是下载量最高的西方模型。这反映出西方开发者在缺乏强力替代品的情况下,仍保持着对旧有架构的依赖。

Qwen的全面加速:Qwen已成为从本地部署、推理加速到多模态工具的默认首选。其下载量在2025年持续攀升,并在年底确立了显著的规模优势。

GPT-OSS的市场反响:OpenAI在2025年下半年推出的开源版GPT (GPT-OSS) 是一股不可忽视的力量。虽然它开始改变美中厂商的下载量平衡(年底时其两个模型的月均下载量大致相当于DeepSeek或Mistral 的总和),但尚未形成压倒性优势。

02

开发者用脚投票:

下载与微调数据

通过分析Hugging Face的下载量(尽管受网页请求干扰存在噪音,仍是最佳衡量标准)和微调(Fine-tuning)数据,可以清晰看到开发者的真实选择。

Qwen的生态位:仅统计2025年12月,下载量最高的5个Qwen3模型(涵盖0.6B到8B参数),其总下载量就超过了OpenAI、Mistral AI、Nvidia、Z.ai、Moonshot AI 和MiniMax所有模型的总和。这种量级上的差距,显示了Qwen在中小参数模型领域的绝对主导地位。

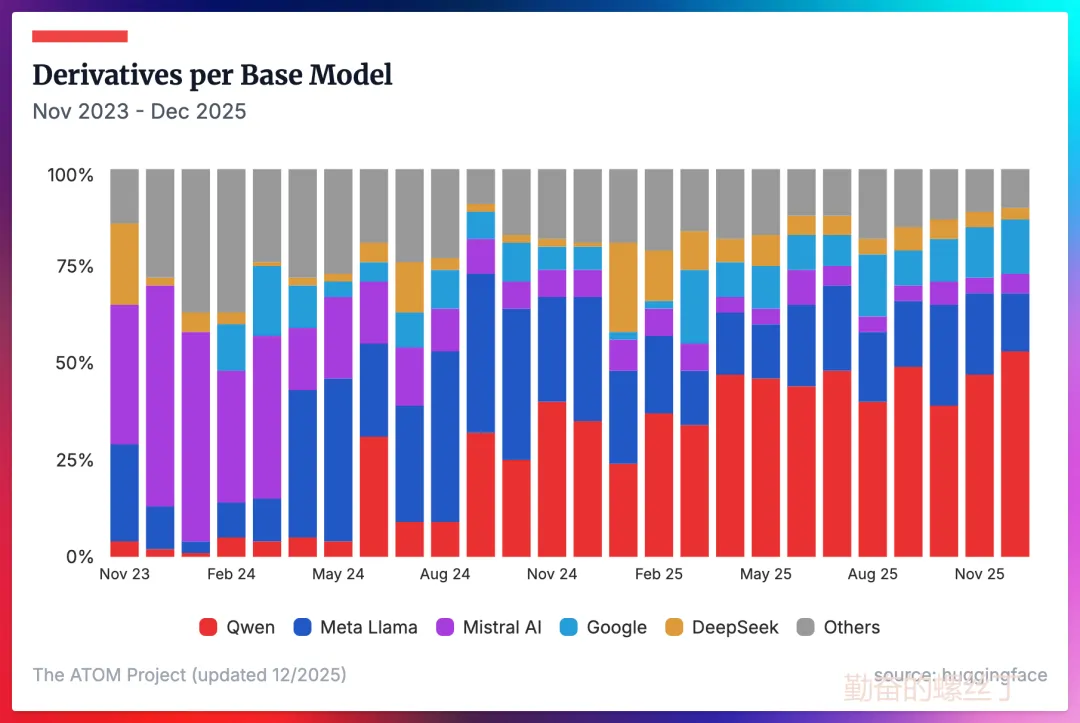

微调集中度:微调数量反映了模型的衍生开发价值。2025年全年,Qwen的衍生模型份额持续增长。目前,开源微调算力高度集中在五大机构:Qwen、Llama、Mistral、Google和DeepSeeK。

03

开源大模型的差异化竞争:

DeepSeek的阵地

数据分析揭示了一个关键细节:Qwen的优势主要集中在中小参数开源模型,而在超大规模参数开源大模型领域留有空白。

Qwen的短板与DeepSeek的机会:在大模型(Large Models)层级,尤其是MoE架构上,DeepSeek(特别是V3和R1版本)在过去两年中保持领先。Nathan Lambert指出,“只有在超大规模参数大模型这一层级,才存在与Qwen竞争的机会。”

实际落地:这一优势已转化为实际应用。例如,知名编程工具Cursor的 Composer模型,正是基于中国的大型MoE模型微调而来,证明了其在前沿应用中的核心价值。

04

新兴势力的挑战

与“统计误差”

尽管行业内对Z.ai、Kimi (Moonshot)、MiniMax等新晋独角兽给予了高度关注,但从全球范围的采用指标来看,它们目前的影响力仍相对有限。

声量与体量的反差:这些模型对于发展本地(中国)生态系统至关重要,但在全球开源指标的统计中,其下载量份额往往极小,被形容为相当于“四舍五入的误差”。

智能水平的角逐:在模型智能水平(Intelligence)的比拼上,中国模型在过去一年多里于大多数基准测试中保持领先。尽管GPT-OSS 120B 曾一度接近榜首(略落后于MiniMax M2),但截至目前,尚未完全扭转这一趋势。值得注意的是,美国在2026年仍极有可能通过GPT-OSS等项目再次拥有“最智能的开源模型”,但这需要进一步的市场验证。

💡 总结洞察

“要扭转这一局面将需要数年时间。”

Nathan Lambert的分析表明,开源生态具有极强的惯性。Qwen通过广泛的尺寸覆盖和性能优化,建立了类似早期Llama的生态壁垒;而 DeepSeek则在高性能开源大模型领域建立了护城河。对于2026年的全球开发者而言,格局已经清晰:

通用与端侧任务:Qwen是事实上的首选标准。

高性能与复杂任务:DeepSeek提供了最佳的开源大模型方案。

西方模型的机会:能否通过GPT-OSS等新项目,在“智能水平”这一高地上重新夺回话语权。

原文链接:https://www.interconnects.ai/p/8-plots-that-explain-the-state-of

勤奋的螺丝丁

微信:Flame_Diligent

一个非典型理工男的诗和远方

长按二维码关注