◾️

相信关注芯片、AI的朋友,早就知道液冷了

前不久英伟达的财报会上,老黄就提到想要采用液冷的数据中心数量,是相当可观

今天给大家分享一篇野村证券的大报告,足足80页

昨天已经提到,液冷在数据中心中增速最快,这篇更表示,明年TAM将是十倍

◾️

一起来看看

◾️

1.什么是液冷技术?

用液体来散热

比起风冷,在AI数据中心中有显著优势

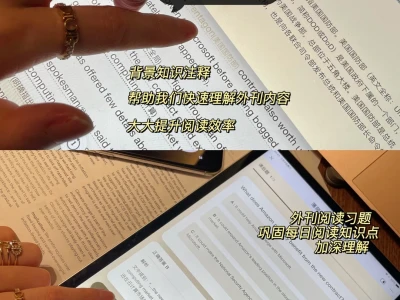

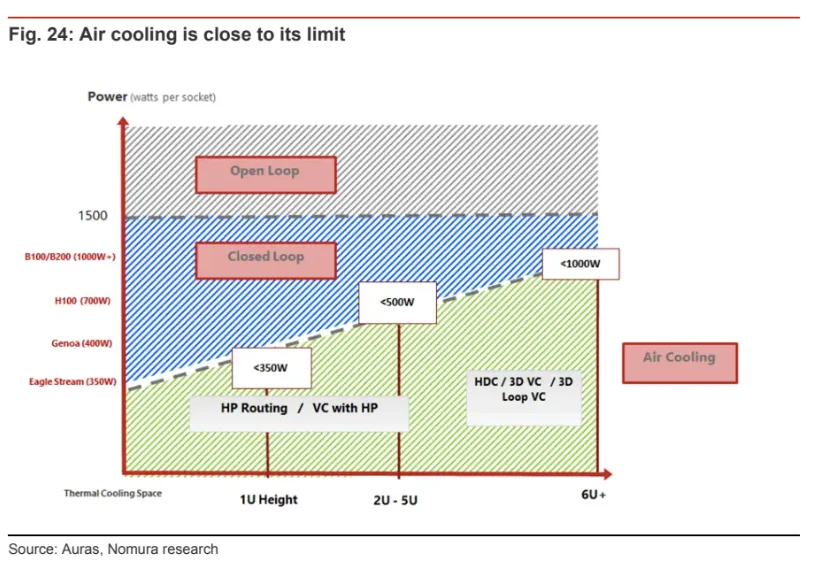

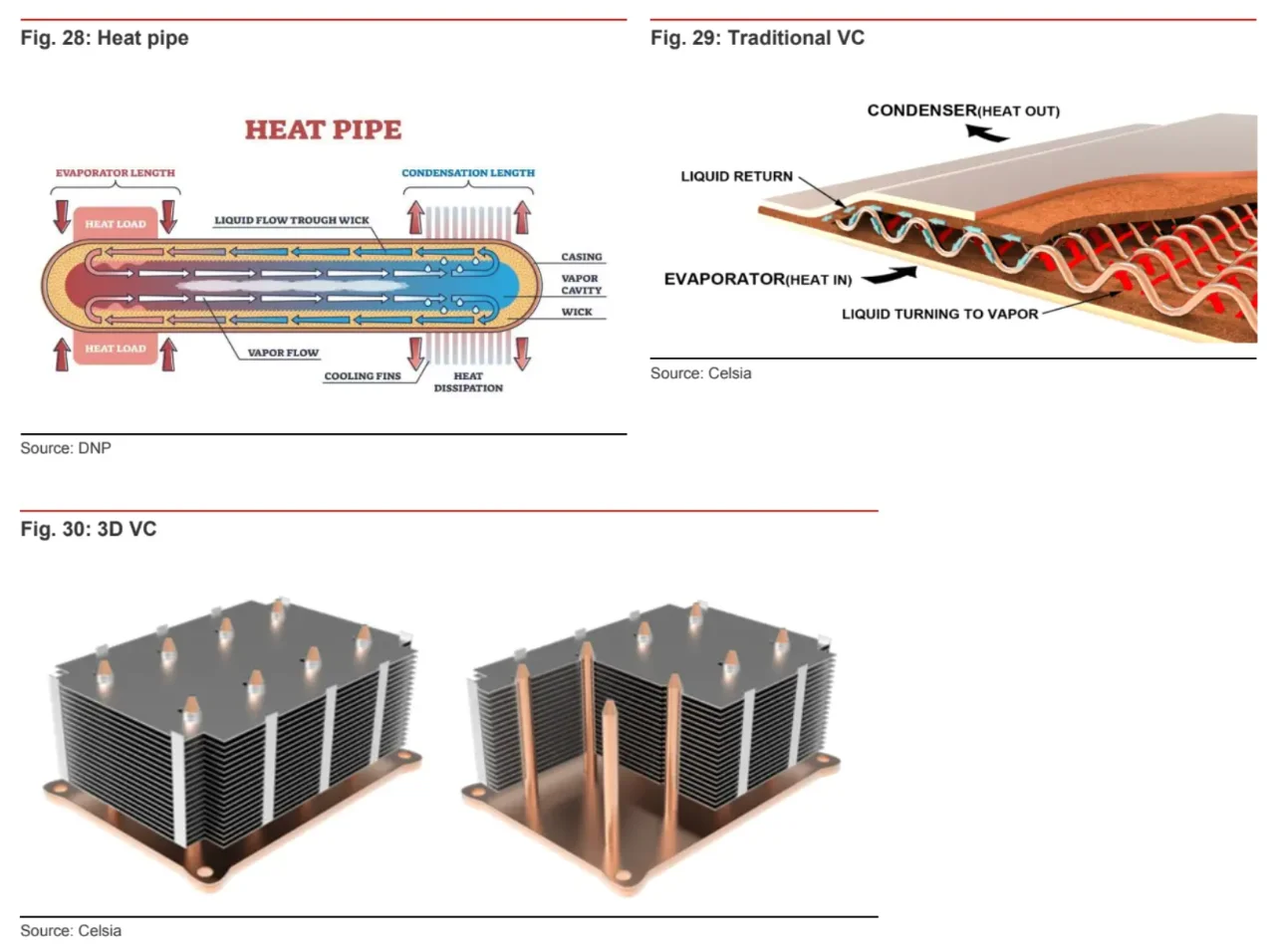

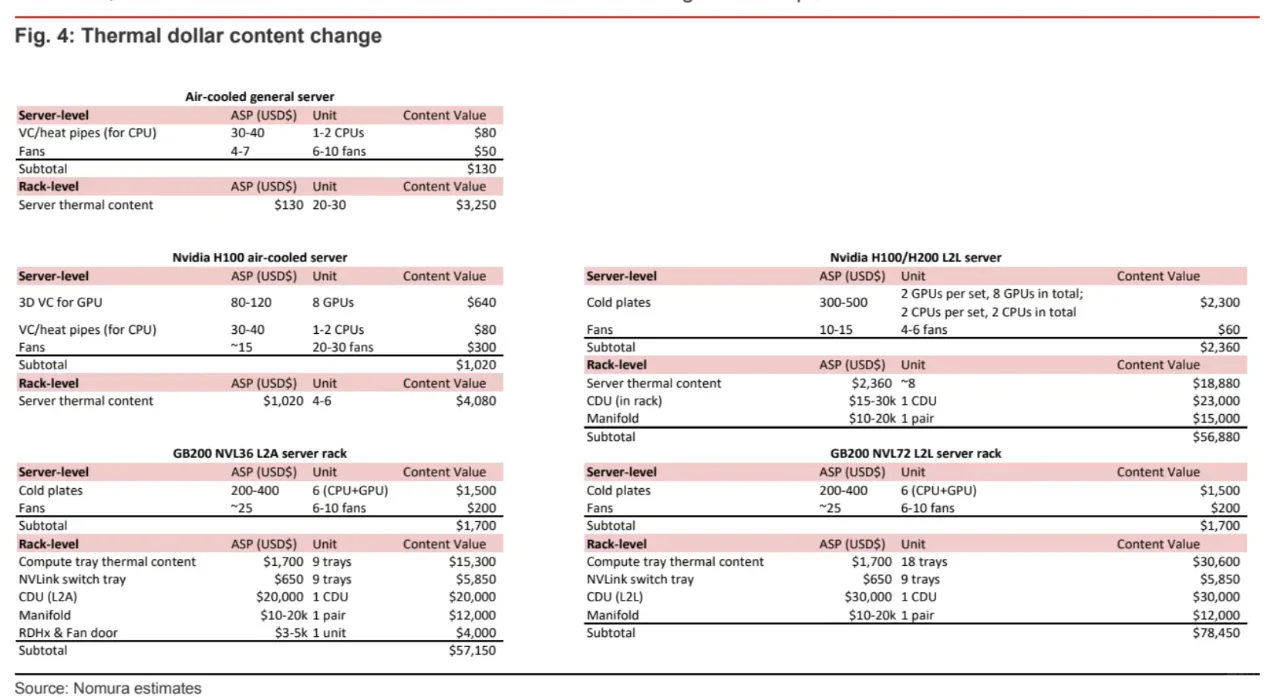

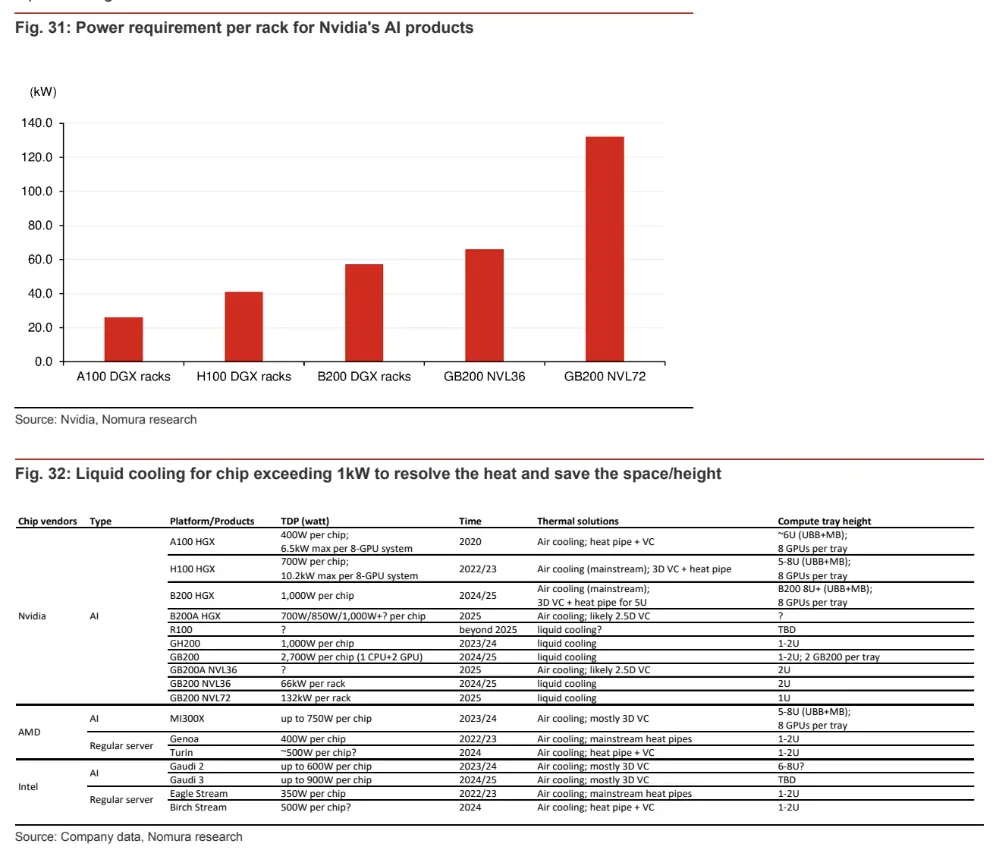

- 向加速计算的转型,要求更高机架密度,更多电力及散热需求,而空气冷却已不能满足,技术可以参考p2-4

- 液体导热效率是空气的30倍,还能将数据中心的电能使用效率(PUE)从1.5以上降低到1.2甚至更低,能耗和运营支出都会更低

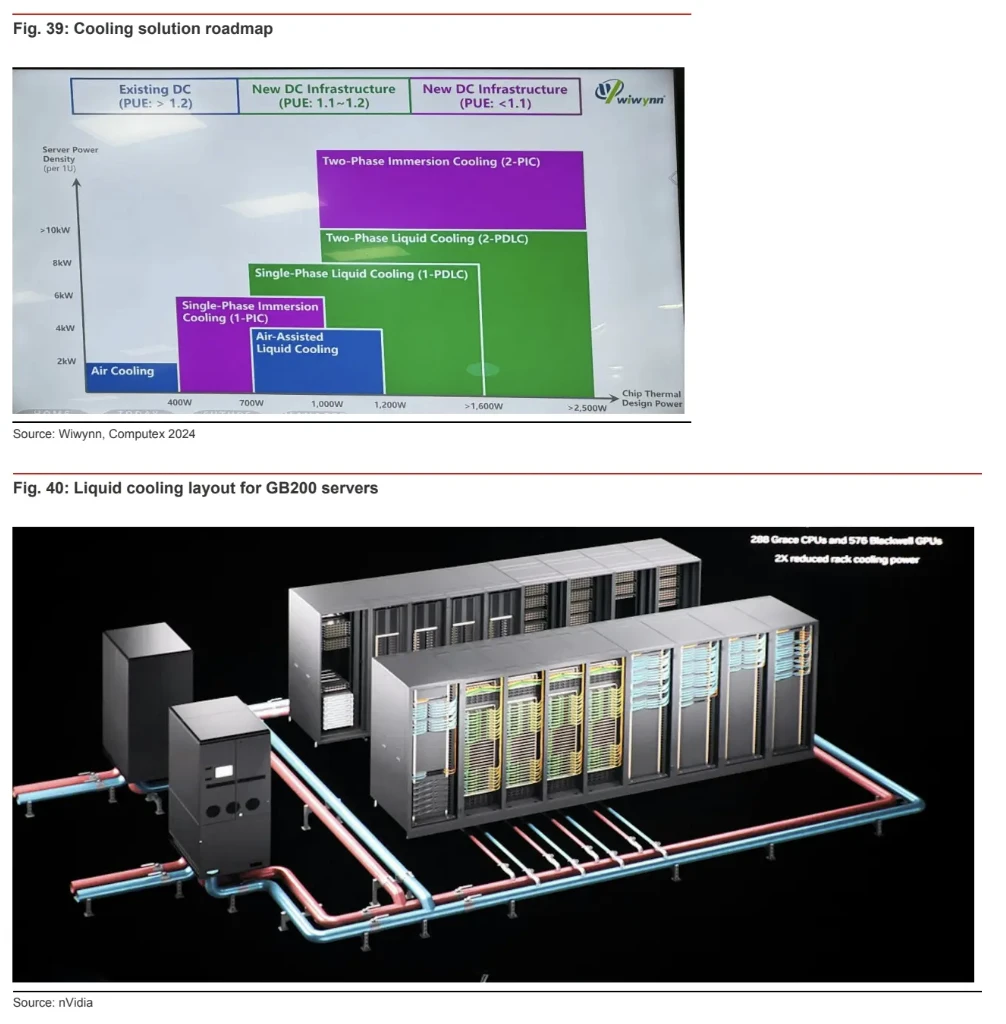

- 出于经济性考量,即使B200 HGX可通过风冷来散热,云服务厂商,也在为它们在考虑液冷方案

据SuperMicro 反馈,DLC(直接液体冷却)方案在五年内可节省$6000万,他们还计划大大提高新数据中心中DLC占比,从过去1%到24年15%,25-26年达30%

液冷真的在这一波AI革命中形成了流行趋势

◾️

2.液冷带来多大市场机会?

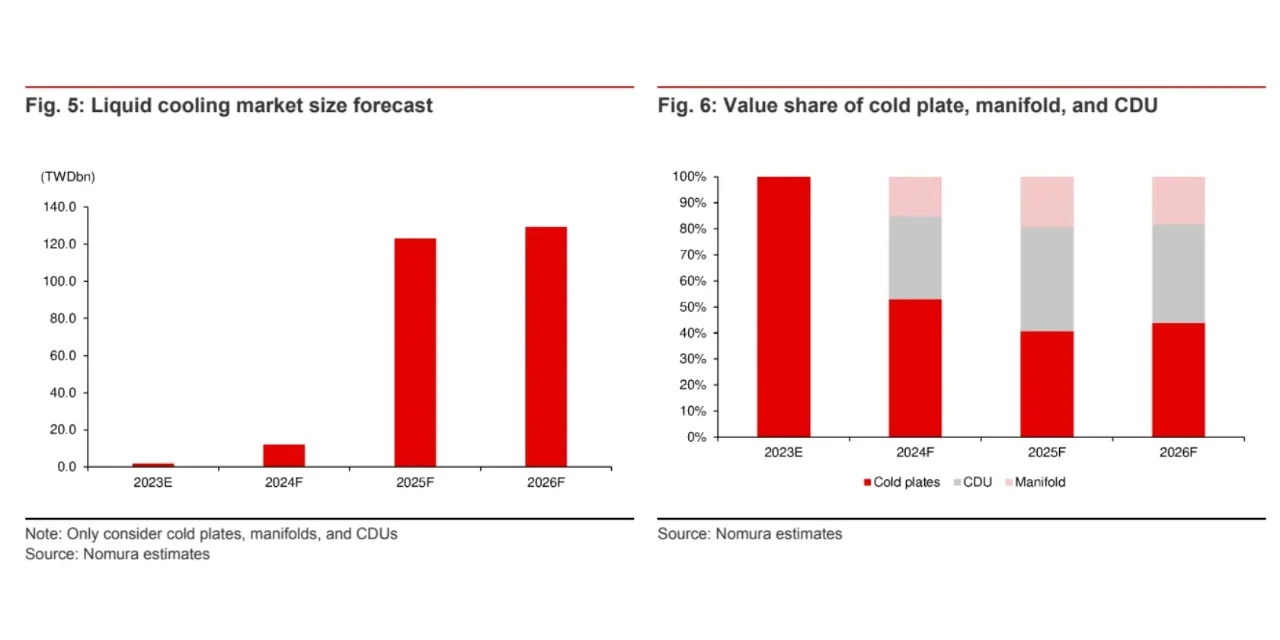

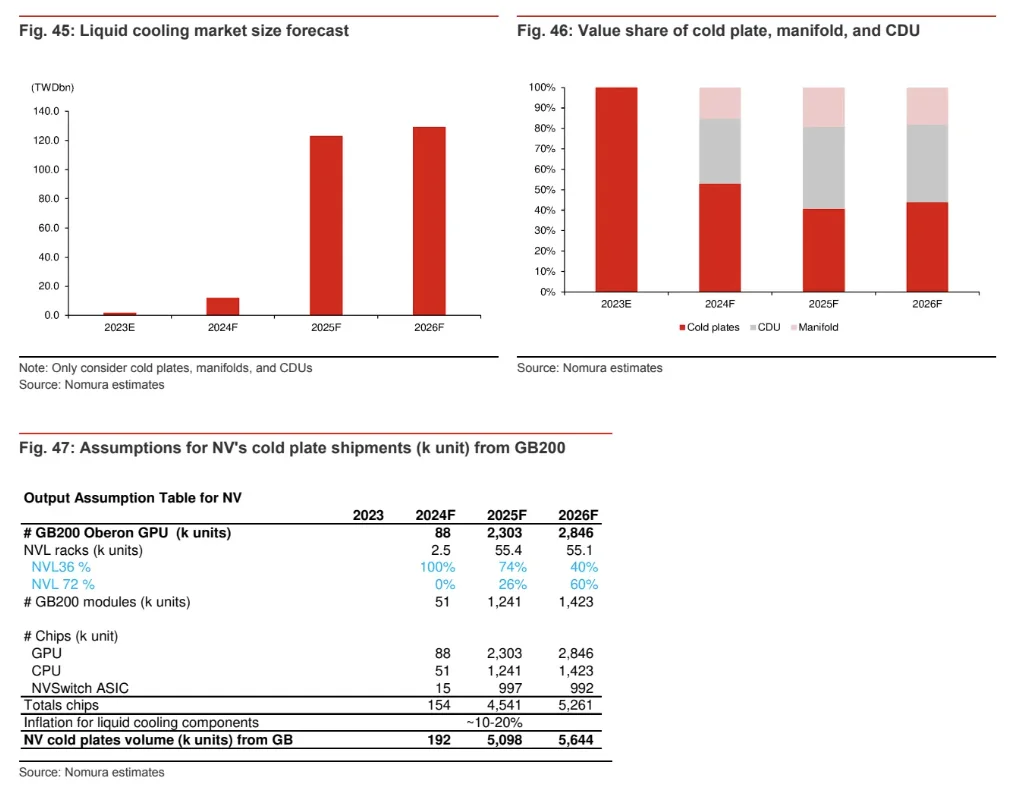

市场在爆发,25年TAM将增10倍 ,见p5-6

规模从23年17亿新台币,飙升到25年1229亿新台币,26年1292亿新台币

在AI服务器中的渗透率,从24年的8%迅速上升到25年43%,26年47%

◾️

3.这个TAM怎么估算?

从AI服务器需求,得到对应机架数,再得到对应的散热组件

并不是所有机架都采用液冷散热,对不同机架用什么散热方式也做了判断

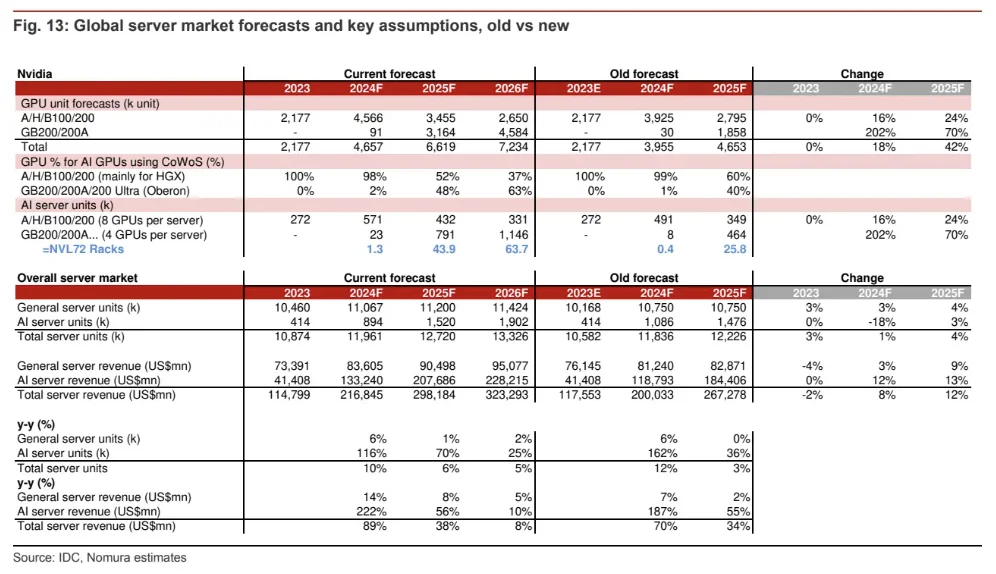

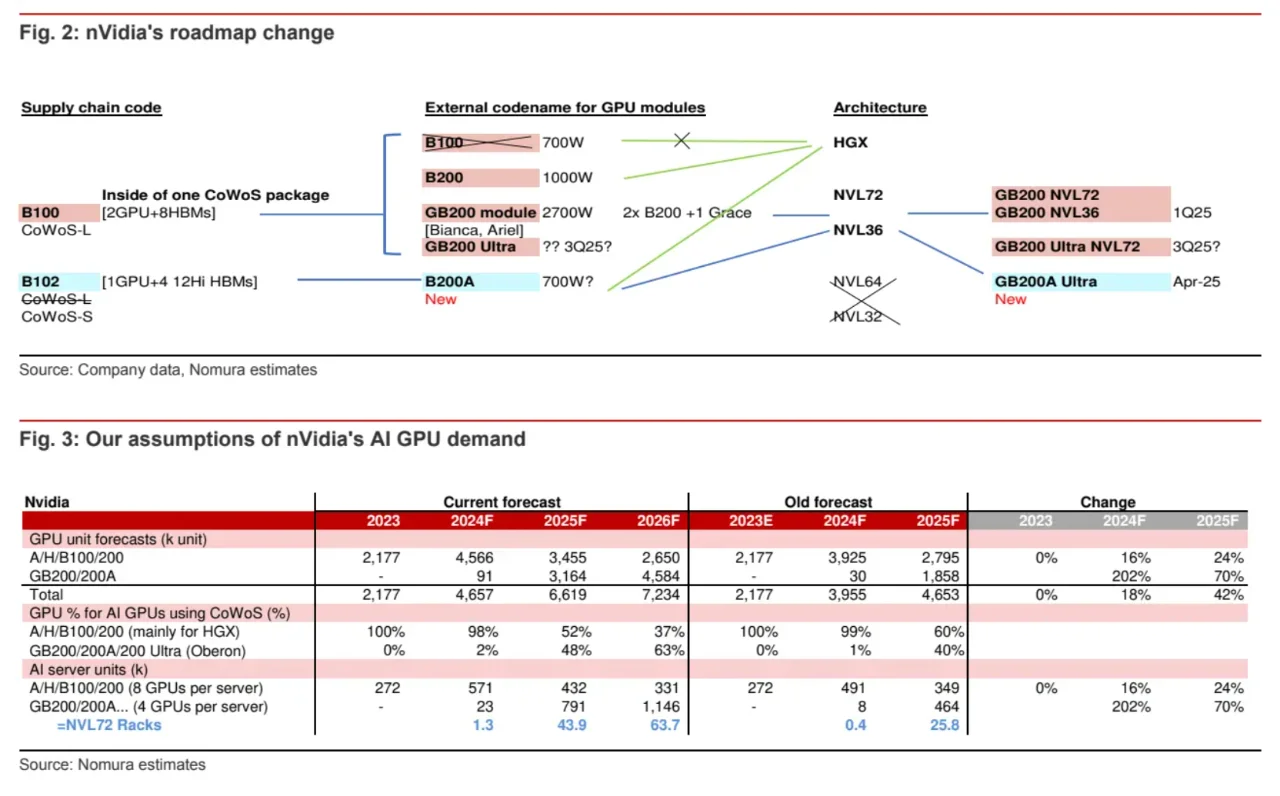

还考虑了英伟达在Blackwell延迟后的新技术路径,带来的影响

测算模型见p7-9

◾️

4.AI服务器的产业链和市场增速如何?

液冷和AI服务器息息相关

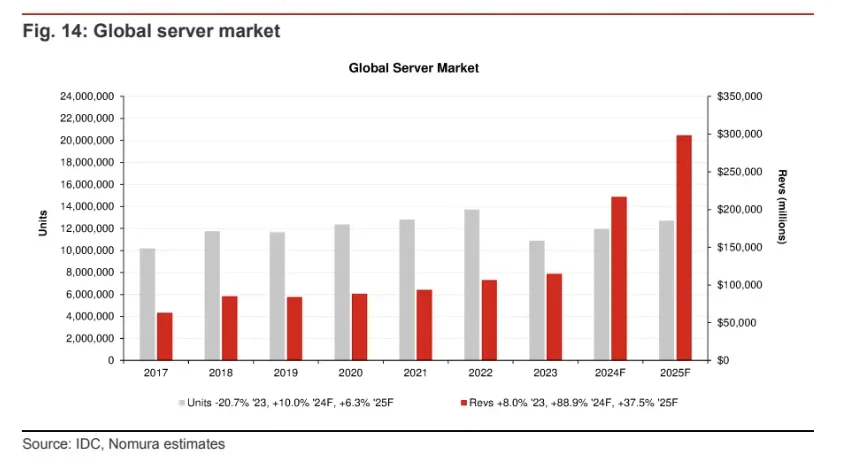

全球服务器市场24年将增长89%,25年38%

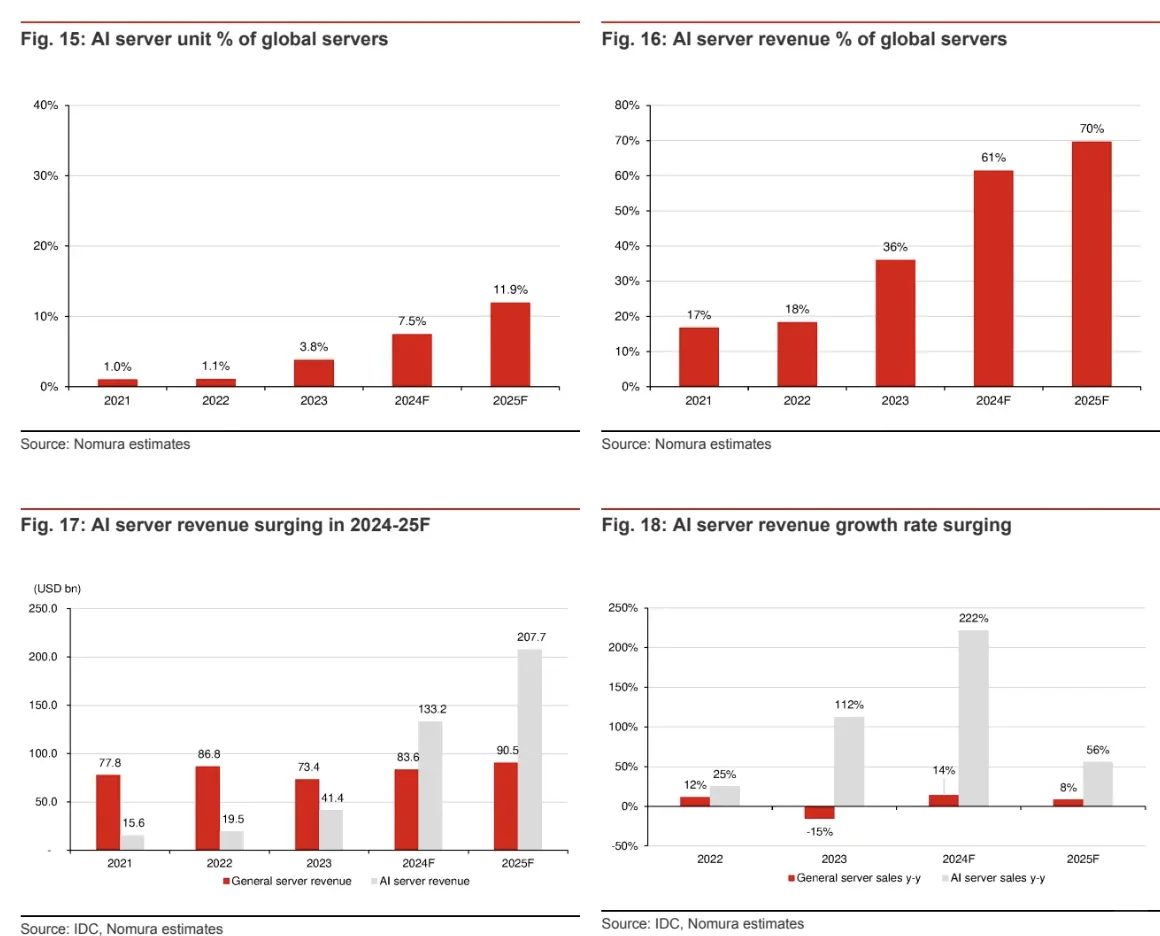

其中,AI服务器的增速更高,24年预计增长222%,25年56%,见p10-11

具体测算见p12

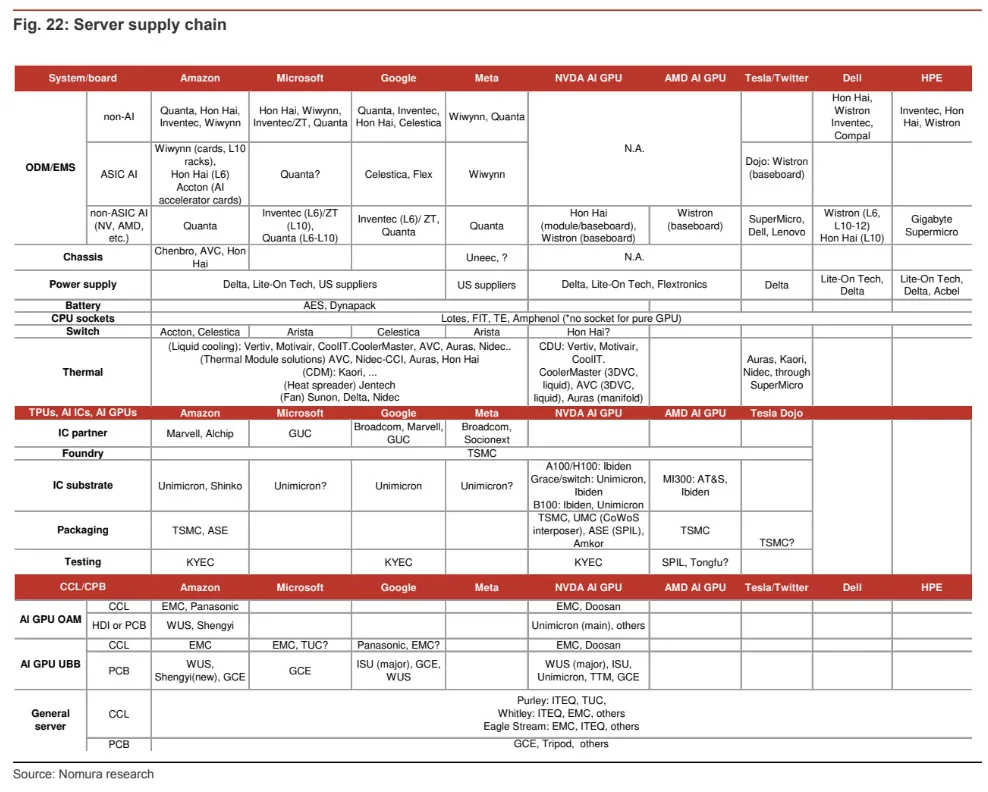

产业链分成,上游-芯片设计,中游-制造和组装,下游-系统集成和应用,这三个环节,见p13-14

代表公司,是英伟达,台积电,亚马逊云

◾️

5.液冷有哪些公司值得了解?

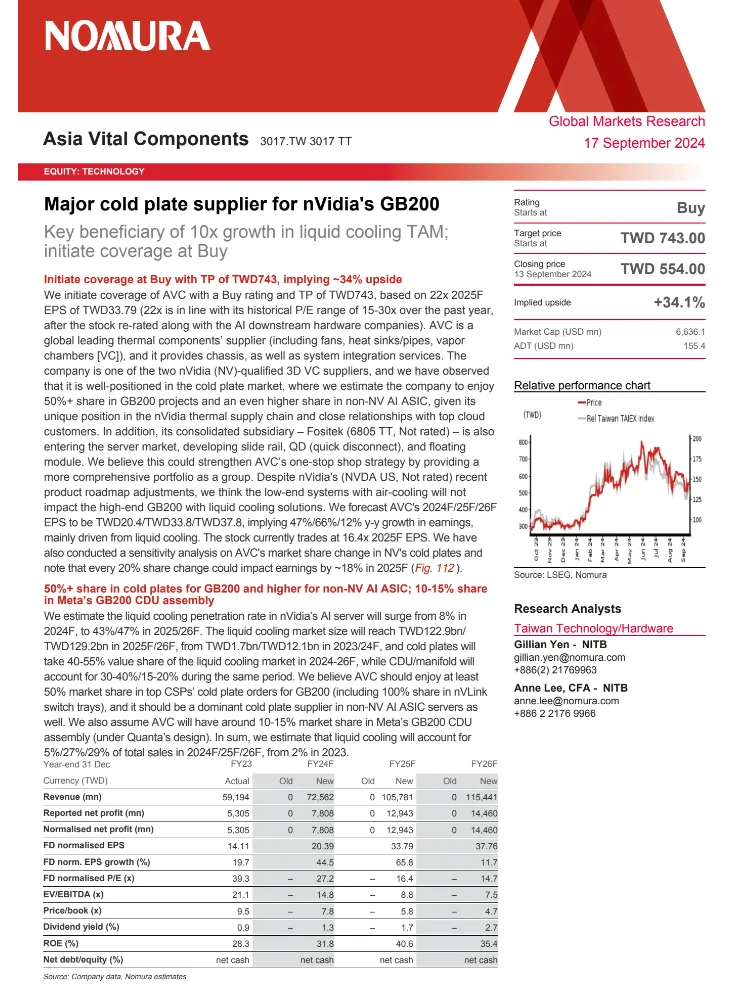

AVC奇鋐,全球领先的散热组件供应商

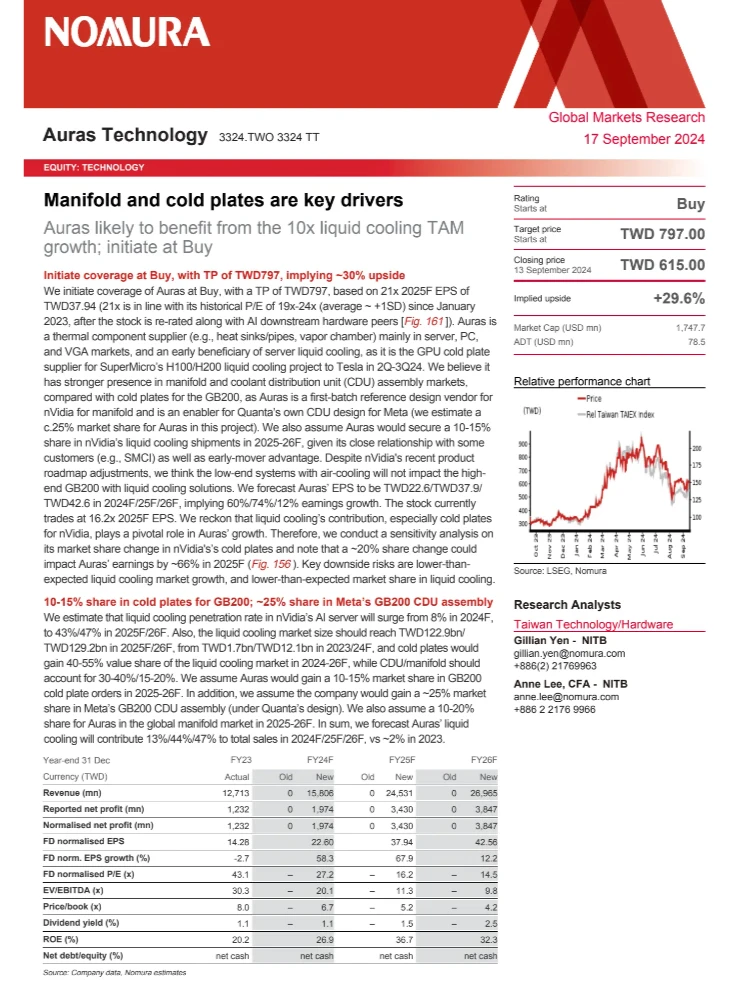

Auras Technology双鸿,另一家散热解决方案提供商

报告中分别有10多页和20多页介绍

对其他公司,Delta Electronics 台达电子、Nidec 、Envicool 深圳英维克,也有介绍

感兴趣可以看后面图片

#研报 #ai #数据中心 #液冷 #服务器

相信关注芯片、AI的朋友,早就知道液冷了

前不久英伟达的财报会上,老黄就提到想要采用液冷的数据中心数量,是相当可观

今天给大家分享一篇野村证券的大报告,足足80页

昨天已经提到,液冷在数据中心中增速最快,这篇更表示,明年TAM将是十倍

◾️

一起来看看

◾️

1.什么是液冷技术?

用液体来散热

比起风冷,在AI数据中心中有显著优势

- 向加速计算的转型,要求更高机架密度,更多电力及散热需求,而空气冷却已不能满足,技术可以参考p2-4

- 液体导热效率是空气的30倍,还能将数据中心的电能使用效率(PUE)从1.5以上降低到1.2甚至更低,能耗和运营支出都会更低

- 出于经济性考量,即使B200 HGX可通过风冷来散热,云服务厂商,也在为它们在考虑液冷方案

据SuperMicro 反馈,DLC(直接液体冷却)方案在五年内可节省$6000万,他们还计划大大提高新数据中心中DLC占比,从过去1%到24年15%,25-26年达30%

液冷真的在这一波AI革命中形成了流行趋势

◾️

2.液冷带来多大市场机会?

市场在爆发,25年TAM将增10倍 ,见p5-6

规模从23年17亿新台币,飙升到25年1229亿新台币,26年1292亿新台币

在AI服务器中的渗透率,从24年的8%迅速上升到25年43%,26年47%

◾️

3.这个TAM怎么估算?

从AI服务器需求,得到对应机架数,再得到对应的散热组件

并不是所有机架都采用液冷散热,对不同机架用什么散热方式也做了判断

还考虑了英伟达在Blackwell延迟后的新技术路径,带来的影响

测算模型见p7-9

◾️

4.AI服务器的产业链和市场增速如何?

液冷和AI服务器息息相关

全球服务器市场24年将增长89%,25年38%

其中,AI服务器的增速更高,24年预计增长222%,25年56%,见p10-11

具体测算见p12

产业链分成,上游-芯片设计,中游-制造和组装,下游-系统集成和应用,这三个环节,见p13-14

代表公司,是英伟达,台积电,亚马逊云

◾️

5.液冷有哪些公司值得了解?

AVC奇鋐,全球领先的散热组件供应商

Auras Technology双鸿,另一家散热解决方案提供商

报告中分别有10多页和20多页介绍

对其他公司,Delta Electronics 台达电子、Nidec 、Envicool 深圳英维克,也有介绍

感兴趣可以看后面图片

#研报 #ai #数据中心 #液冷 #服务器